L'évolution du rôle des femmes dans la société française : un regard sociologique

Lisez ci-dessous pour découvrir comment le rôle des femmes dans la société française a évolué au cours des derniers siècles et comment cela a façonné la France moderne.

Contexte historique

Le rôle des femmes dans la société française a subi des changements radicaux au cours des dernières décennies, grâce à des mouvements féministes et à une évolution progressive des mentalités. Historiquement, les femmes ont été reléguées à des rôles subalternes, confinées à la sphère privée du foyer et de la famille. Cependant, les deux Guerres Mondiales ont marqué un tournant, avec les femmes qui ont été appelées à travailler dans les usines pour soutenir l’effort de guerre.

Les tendances sociétales actuelles

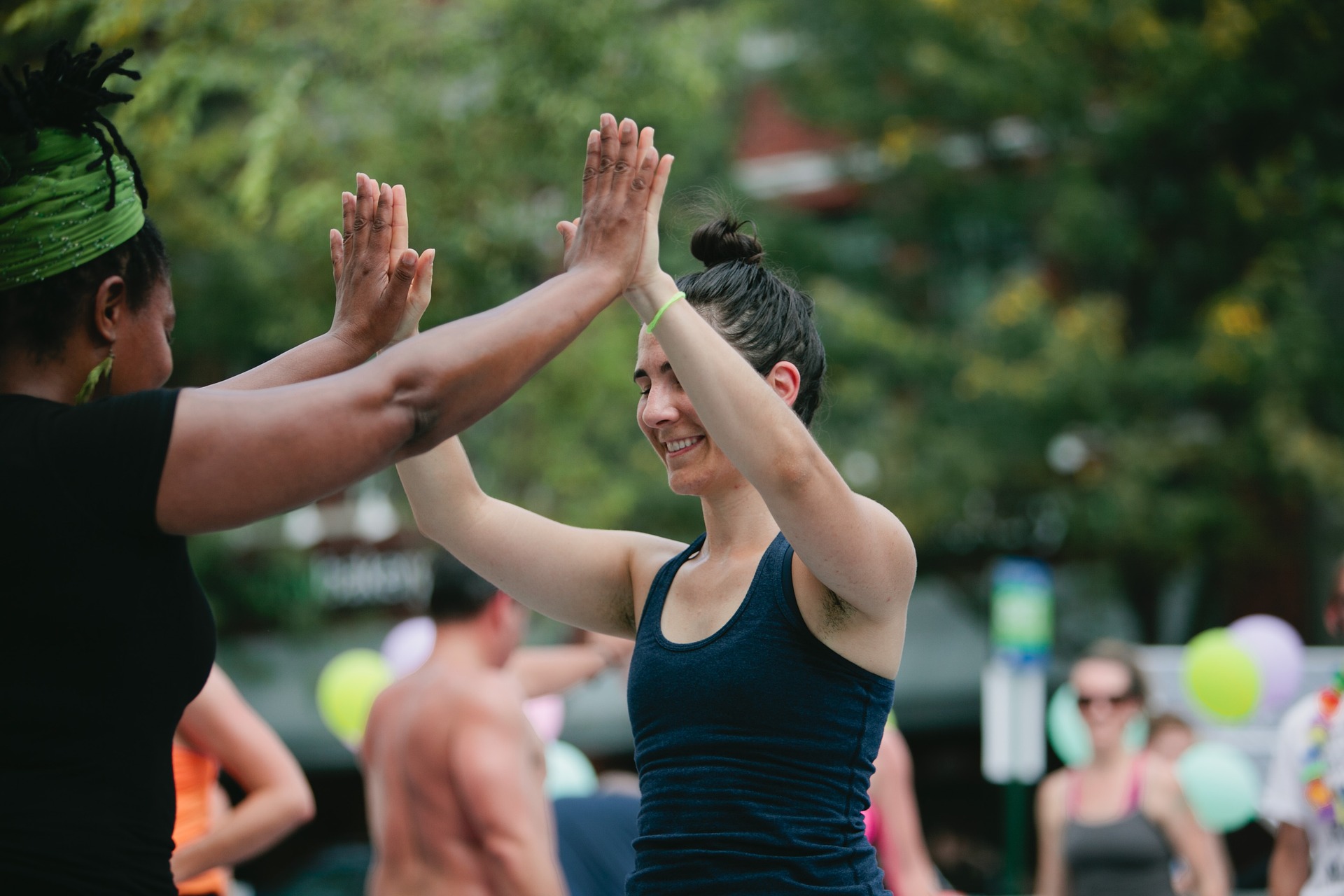

Aujourd’hui, les femmes jouent un rôle essentiel dans tous les secteurs de la société française, de la politique à l’économie, en passant par la culture et la science. Le mouvement #MeToo a également eu un impact significatif en France, mettant en lumière les inégalités de genre et encourageant un dialogue ouvert sur les violences sexistes et sexuelles.

Les implications du changement de rôle des femmes

L’évolution du rôle des femmes a des implications profondes pour la société française. D’une part, cela a conduit à une plus grande égalité des genres, avec des lois garantissant l’égalité salariale et l’équilibre entre la vie professionnelle et la vie privée. D’autre part, cela a également alimenté des débats sur des sujets tels que le partage des responsabilités familiales et l’égalité des chances.

Les preuves sociologiques

Des études sociologiques ont montré que l’égalité des sexes est bénéfique pour la société dans son ensemble, conduisant à une croissance économique plus forte, à une meilleure santé et à une plus grande stabilité sociale. De plus, l’égalité des genres favorise l’innovation et la créativité, des éléments clés pour une société dynamique et progressiste.

Une analyse plus profonde

En fin de compte, l’évolution du rôle des femmes en France est le reflet d’une société en constante évolution. C’est un processus qui exige une réflexion continue et un engagement à repousser les limites de ce qui est possible. La France, avec son histoire riche et complexe, offre un contexte unique pour étudier ces dynamiques et comprendre comment les changements sociaux peuvent façonner une nation.

En conclusion, le rôle des femmes dans la société française a évolué de manière significative au cours des dernières décennies. Cependant, il reste encore beaucoup à faire pour atteindre une véritable égalité des genres. En continuant à questionner et à défier les normes, nous pouvons espérer construire une société plus équitable et inclusive pour tous.